Quand externaliser infogérance Linux : le guide décisionnel pour PME et SaaS

Externaliser l’infogérance Linux n’est pas une question “de mode”, c’est une décision de pilotage. Si ton équipe perd du temps sur des incidents répétitifs, si la sécurité avance en pointillés, et si la production dépend de quelques personnes clés, il est temps de structurer l’exploitation avec une méthode claire.

Cette page te donne un cadre concret pour décider au bon moment : signaux à surveiller, coûts cachés de l’inaction, modèle d’accompagnement adapté, et critères à exiger pour éviter l’effet “prestataire boîte noire”.

Réponse rapide

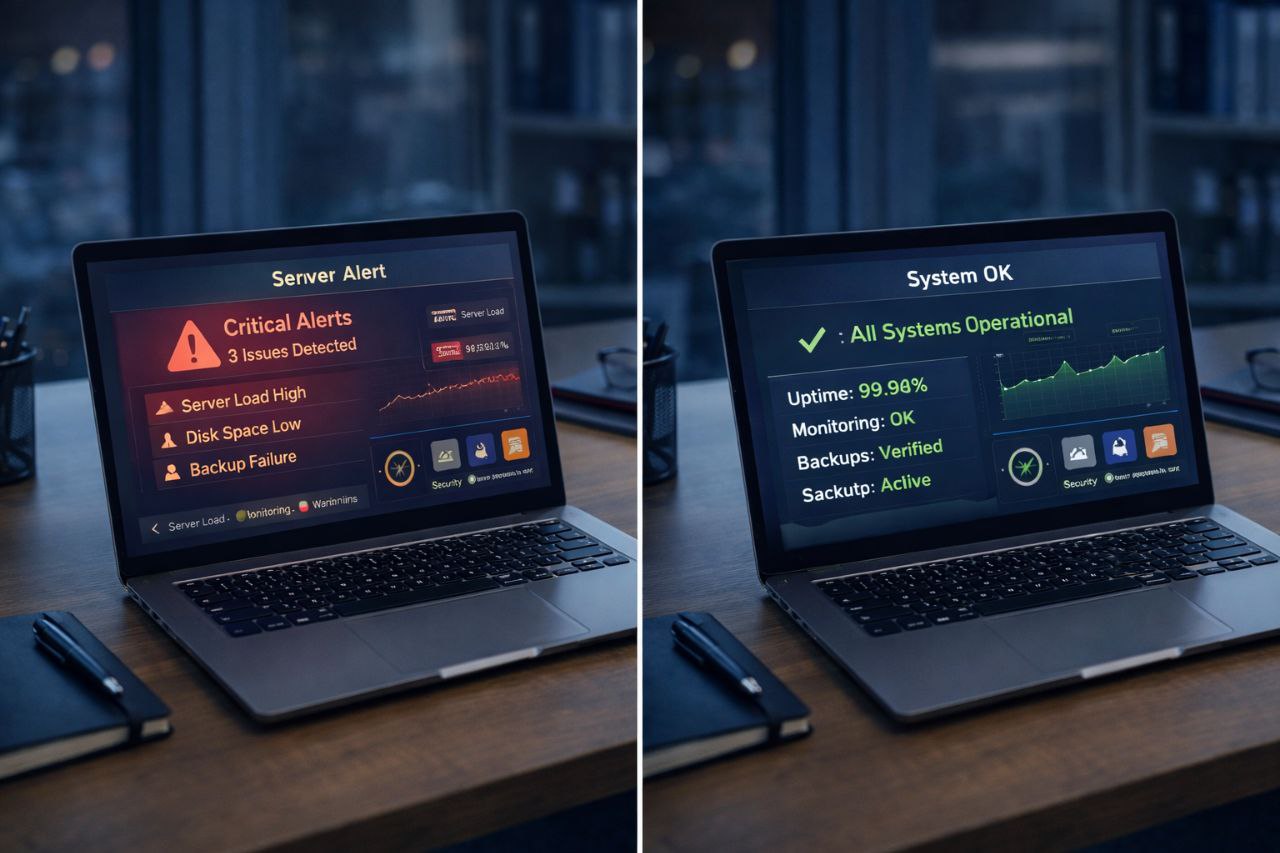

Tu dois externaliser l’infogérance Linux quand l’exploitation freine la roadmap : incidents récurrents, monitoring inutilisable, sauvegardes non vérifiées, déploiements fragiles, dette sécurité qui s’accumule. Si ces signaux persistent 4 à 8 semaines, l’externalisation devient une décision business prioritaire.

Pourquoi les équipes attendent trop longtemps

Les urgences sont traitées, mais les causes racines ne le sont pas.

Le coût des interruptions et retards n’est pas mesuré formellement.

“On gère en interne” mais au prix d’une forte dépendance humaine.

Les 7 signaux qui indiquent qu’il faut externaliser

- Incidents répétitifs : mêmes symptômes, mêmes causes, mêmes urgences.

- Alerting bruité : trop d’alertes non actionnables, incidents détectés tard.

- Sécurité irrégulière : patching, accès, secrets sans routine fiable.

- Backups non prouvés : sauvegardes présentes, restaurations non testées.

- Déploiements risqués : manipulations manuelles, rollback incertain.

- Dépendance à une personne : absence = zone de risque.

- Roadmap ralentie : l’équipe produit corrige l’infra au lieu de livrer.

Matrice de décision interne vs externalisation

Score chaque critère de 1 (maîtrisé) à 5 (critique) :

- Fréquence et gravité des incidents

- Qualité de la supervision/observabilité

- Maturité sécurité opérationnelle

- Fiabilité backup/restauration

- Charge infra sur l’équipe dev/produit

Lecture : ≤12 = amélioration interne possible ; 13–18 = modèle hybride conseillé ; ≥19 = externalisation prioritaire.

Coûts cachés de l’inaction

1) Coût opérationnel direct

Chaque incident consomme du temps qualifié (dev, support, management), génère des interruptions et parfois des pénalités implicites (retards projet, churn client, baisse de confiance).

2) Coût d’opportunité produit

Le temps passé à “tenir la prod” n’est pas investi sur la roadmap commerciale. À terme, c’est un coût de croissance.

3) Coût humain

Une exploitation subie crée fatigue, turnover et perte de qualité dans les décisions techniques.

3 modèles d’externalisation qui fonctionnent

Kickstart

Objectif : reprendre le contrôle vite.

Livrables : diagnostic, quick wins, plan priorisé.

Délai : 2 à 5 jours.

Build

Objectif : fiabiliser durablement.

Livrables : standards infra, monitoring, sécurité, process incident.

Délai : 1 à 4 semaines.

Run

Objectif : piloter dans la durée.

Livrables : suivi mensuel, support incidents, amélioration continue.

Rythme : mensuel.

🚀 Obtenir un plan d’action initial en 30 min

Plan 30 / 60 / 90 jours après externalisation

0–30 jours : stabilisation

- Cartographie rapide des risques

- Quick wins sécurité/exploitation

- Priorisation claire des urgences réelles

30–60 jours : structuration

- Mise en place supervision utile et alerting actionnable

- Process incident et runbooks

- Routine patching + sauvegarde/restauration

60–90 jours : industrialisation

- Standardisation des déploiements

- KPI d’exploitation partagés

- Cadre d’amélioration continue

SLA/KPI à exiger pour garder le contrôle

- Délai de prise en charge et de résolution cible (MTTR)

- Taux de sauvegardes restaurables (tests réels)

- Suivi patching et exposition sécurité

- Taux d’incidents récurrents (et traitement cause racine)

- Qualité documentaire (runbooks, post-mortems, backlog)

Erreurs à éviter lors de l’externalisation

- Choisir uniquement au prix sans cadre de résultats

- Lancer une mission sans périmètre ni livrables explicites

- Accepter une relation opaque sans indicateurs partagés

- Ne pas prévoir de transfert de connaissances

Préparer un échange utile (2 minutes)

- Stack actuelle + hébergement + environnements

- 3 incidents récents les plus coûteux

- Niveau d’urgence (faible/moyen/élevé)

- Objectif business prioritaire sur 90 jours

Cas pratiques : décider avec des faits

Cas A — SaaS B2B en croissance

L’équipe produit livre vite, mais la prod génère des alertes en continu. Les déploiements passent, mais chaque release augmente la pression. Ici, le bon choix est souvent un modèle hybride : Kickstart pour poser un diagnostic objectif, puis Build ciblé sur observabilité, sécurité d’accès et standardisation des déploiements.

Bénéfices concrets : moins d’interruptions non planifiées, meilleure prévisibilité des releases, baisse du temps de résolution incident.

Cas B — PME avec infra historique

Infrastructure fonctionnelle mais peu documentée, dépendante d’une personne. Les sauvegardes existent, mais sans tests de restauration. Dans ce contexte, externaliser permet de sécuriser la continuité avant qu’un incident humain (absence, départ) ne devienne un incident business.

Bénéfices concrets : réduction du risque de dépendance, documentation exploitable, meilleure résilience opérationnelle.

Cas C — Équipe dev saturée

Les développeurs gèrent aussi l’exploitation “par nécessité”. Chaque incident mange du temps produit et retarde la roadmap. Externaliser l’exploitation courante redonne de la capacité aux devs et améliore la qualité des arbitrages.

Bénéfices concrets : focus équipe sur la valeur métier, cadence de livraison plus stable, baisse de la charge mentale.

Comment cadrer un appel de 30 minutes (script prêt à l’emploi)

- Contexte (5 min) : stack, hébergement, organisation, criticité métier.

- Douleurs prioritaires (10 min) : incidents, points de friction, contraintes.

- Objectif 90 jours (10 min) : ce qu’il faut améliorer en priorité.

- Plan initial (5 min) : quick wins + trajectoire + modèle d’intervention.

Ce format évite les échanges vagues et permet de sortir du call avec une direction claire.

Grille de scoring prestataire (prête à copier)

Note chaque critère de 1 à 5, puis compare objectivement les options :

- Expérience Linux production (PME/SaaS)

- Maturité sécurité opérationnelle

- Qualité supervision/alerting

- Méthode backup/restauration

- Transparence process + documentation

- Capacité de transfert de compétences

- Clarté des livrables et KPI

Lecture : un prestataire techniquement bon mais opaque reste risqué. Privilégie la combinaison “compétence + méthode + transparence”.

Sources utiles (bonnes pratiques et références)

- Google SRE Book (pratiques fiabilité)

- OWASP Top 10 (risques applicatifs)

- CISA Secure by Design

- CNIL — sécurité des systèmes

Objections fréquentes (et réponses pragmatiques)

“On va perdre la main sur notre infra”

Perdre la main arrive surtout quand la mission est mal cadrée. Avec des KPI partagés, des runbooks versionnés, des points de suivi fixes et une documentation vivante, tu conserves le pilotage tout en déléguant l’exécution opérationnelle.

“Notre contexte est trop spécifique”

C’est justement le rôle d’un bon accompagnement : partir de l’existant, prioriser ce qui a le plus d’impact, et éviter les “refontes totales” inutiles. La spécialisation ne s’oppose pas à la standardisation ; elle la rend exploitable.

“On attend de recruter”

Recruter peut prendre plusieurs mois. Pendant ce temps, les risques continuent de croître. Externaliser temporairement permet de stabiliser la production et de préparer une reprise interne propre si besoin.

Ce que doit contenir une proposition sérieuse

- Périmètre explicite : ce qui est inclus, ce qui ne l’est pas, et pourquoi.

- Objectifs mesurables : disponibilité, MTTR, sécurité, qualité de monitoring.

- Rythme de pilotage : hebdo/mensuel, reporting, revue des priorités.

- Livrables obligatoires : runbooks, plan d’action, docs de reprise.

- Plan de réversibilité : reprise interne possible sans perte de connaissance.

Mini feuille de route de décision (7 jours)

- Jour 1–2 : lister incidents + impacts business récents.

- Jour 3 : scorer la matrice interne/externalisation.

- Jour 4 : identifier les quick wins attendus sous 30 jours.

- Jour 5 : comparer 2 options de périmètre (Kickstart vs Build).

- Jour 6–7 : décider et lancer avec KPI de suivi dès le départ.

Cette méthode évite les décisions émotionnelles et ancre la démarche sur des faits.

FAQ

Externaliser veut-il dire perdre le contrôle ?

Non, si la mission est pilotée avec KPI, points de suivi, documentation et arbitrages explicites.

Peut-on commencer sans engagement long ?

Oui, un Kickstart court permet de décider sur des faits avant de passer en Build/Run.

Que garde l’équipe interne ?

Les décisions produit et les arbitrages business restent internes ; l’exploitation devient plus prévisible.

Est-ce réversible ?

Oui, avec standards, runbooks et transfert de compétences, la reprise interne est possible.

Ressources complémentaires

- Prestataire infogérance Linux PME : comment choisir

- Infogérance Linux pour PME

- Déploiements et automatisation serveurs (éditeurs/SaaS)

- Audit et plan de gouvernance infrastructure

Conclusion

Le bon timing pour externaliser l’infogérance Linux, c’est avant la crise majeure. Si ton exploitation freine la roadmap, on peut cadrer ton contexte et définir un plan d’action priorisé en 30 minutes.

🚀 Obtenir un plan d’action initial en 30 min

Ressource complémentaire maintenance

Si vous avez identifié plusieurs signaux d’alerte, vous pouvez enchaîner avec ce guide opérationnel : maintenance serveurs Linux PME : checklist anti-incidents. Il détaille la cadence hebdo/mensuelle, les KPI à suivre et un cadre SLA pragmatique.